数据精英年终大冲刺开车啦!

同时报名还可享更多优惠:

任选2套同报,再减200元!

任选3套同报,再减360元!

任选4套同报,再减520元!

任选5套同报,再减700元!

任选6套同报,再减900元!

项目名称:面向多元空间融合的视觉计算与图像质量评价

项目负责人:高新波

依托单位:西安电子科技大学

项目参与人:

吕建成 教授 四川大学

路文 副教授 西安电子科技大学

邓成 副教授 西安电子科技大学

王斌 副教授 西安电子科技大学

王秀美 副教授 西安电子科技大学

何立火 西安电子科技大学

高飞 西安电子科技大学

侯伟龙 西安电子科技大学

刘奇 西安电子科技大学

项目中文摘要

图像质量评价是指通过构建视觉计算模型模拟人类观察和评判图像质量以获得与主观感受相吻合的客观评价结果,目前已广泛应用于卫星遥感、视频监控和消费电子等领域。

本项目旨在通过融合物理空间、信息空间和认知空间,对人类感知-认知机制进行建模,利用稀疏编码和自由能量理论,构建最优图像质量评价的视觉计算模型,设计针对视觉信息保真度、可懂度和美观度的评价准则,提出相应的图像质量评价方法。

主要研究内容包括:面向保真度的图像质量评价,研究图像特征深度构架和最优稀疏特征提取、图像质量标记数据的快速可靠获取和感知质量预测;面向可懂度的图像质量评价,研究物理空间和成像路径的失真建模,混合失真的模型分析与盲分离;面向美观度的图像质量评价,研究美学共性特征和个性化认知的建模与质量评价。

本项目基于视觉计算和感知模型,结合深度学习和阴阳机等先进机器学习方法,构建多元空间融合的图像质量评价新框架,从而丰富与完善视觉计算理论。

项目结题成果报告

以下研究成果内容摘自项目结题成果报告。该项目报告共计119页,关注城市数据派微信公众号,在微信公众号对话框中输入 241125,即可获得报告全文PDF的下载方式:

(1)主要研究内容。

本项目以全面、准确、及时地实现可视媒体的质量预测为目标,以满足人们对视觉保真度、可懂度和美观度三个不同层次质量评价的需求为目的,构建视觉信息的质量评价新测度。针对传统方法的视觉保真度评判不准确、视觉可懂度评估不可靠、视觉美观度评价不真实的问题,基于人类视觉系统对可视媒体的三个层次的感知特性,探索物理空间、信息空间和认知空间相融合的视觉计算机制模拟人类视觉系统的感知-认知过程,构建多元空间融合的层次化、立体式的视觉信息质量评价体系,构建基于云平台的质量评价服务原型系统,以满足人类对不同层次图像质量的评价需求,为可视媒体保真度质量的准确评判、可懂度质量可靠评估和美观度质量的真实评价提供理论依据与技术支撑。

本项目主要是从理论模型、技术方法和应用验证三个层次进行。基于人类视觉系统对可视媒体的保真度、可懂度和美观度三个层次的感知特性,以多空间融合、多层次关联为主线,开展跨物理空间、信息空间和认知空间的可视媒体质量感知-认知研究,构建多元空间融合的视觉信息质量评价。本项目的研究工作可概况为三个方面:视觉计算与图像增强,基于多元空间融合的视觉质量评价,视觉计算与质量评价的应用。

(2)取得的主要研究进展、重要结果、关键数据等及其科学意义或应用前景。

一、视觉计算与图像增强

针对视觉计算问题,主要研究了视觉显著性现理论与方法。针对图像增强问题,主要研究了多光谱图像的解混、图像去雾和图像的超分辨理论与方法。

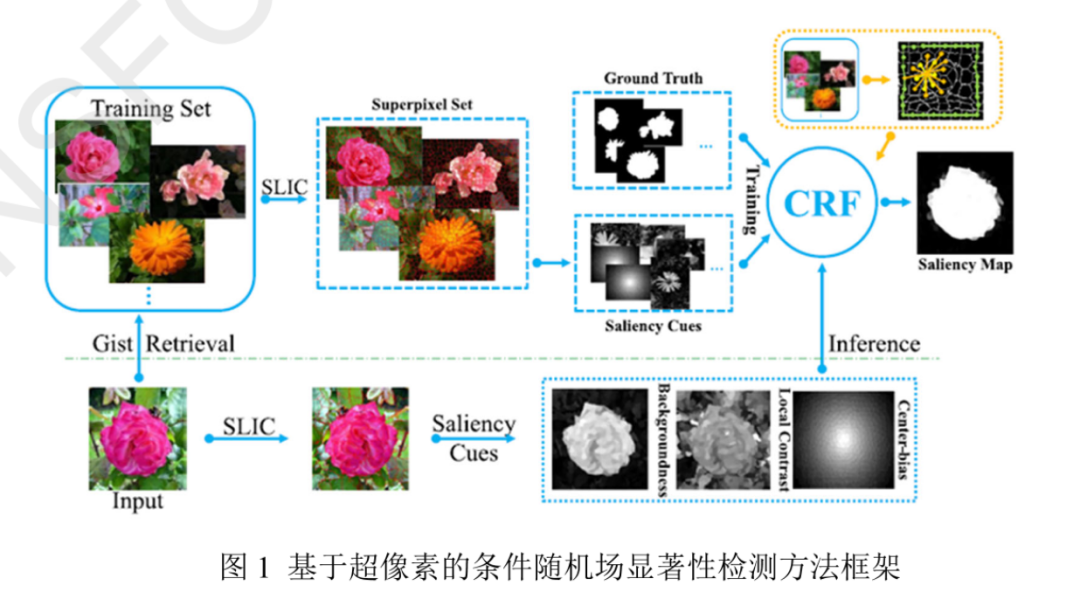

基于视觉注意力的图像和视频显著性检测方法研究。a)研究了基于超像素的条件随机场显著性检测方法。首先,通过线性迭代聚类算法对图像进行过分割将整个场景分解为一组超像素,并使用伪背景图构造一个“双环”。然后,生成三种低维及高维显著性视觉特征,即显著线索,对人眼第一次观察到场景的情形进行建模。最后,引入条件随机场,对不同的显著线索进行融合,最终获得清晰的物体边缘及纯背景。b)研究了人类视觉注意力特性,提出了一种基于多色空间测地距离融合和基于总方差的成对交互模型的眼动辅助视频显着性检测方法。首先将眼睛注视点映射到过分割的视频帧,并逐步将注视范围扩展到显着区域,然后获取帧的前景和背景之间潜在的成对关系,以此推断其余帧的显著性值,实现视频的显著性检测。相关研究成果发表在国际重要期刊Neurocomputing和IEEETransactions on Image Processing £ 。[1]Wenliang Oiu, Xinbo Gao*, and Bing Han, Eye Fixation Assisted Video SaliencyDetection via Total Variation-Based Pairwise Interaction, IEEE TransactionsImage Processing (IEEE TIP),Vol.27,No.10,pp.4724-4739,2018.[2]Wenliang Qiu, Xinbo Gao*, and Bing Han, A Superpixel-based CRF SaliencyDetection Approach,Neurocomputing, Vol.244,pp.19-32.2017.

a)基于超像素的条件随机场(CRF)显著性检测方法

现有方法生成的显著性特征图不具备清晰边缘及纯背景。针对该问题,提出了一种基于超像素的条件随机场显著性检测方法。该方法为传统的条件随机场提供基于超像素的概率图,为每个超像素块提供更多的邻域与边缘特征,使之在模型中更好地进行学习与推断。针对传统像素图无法有效抑制噪声区域的问题,超像素图将噪声区域作为一个整体来处理,通过其相邻的非显著性超像素,在语义和结构上进行修改,克服噪声问题并得到一个纯背景。受到背景中非显著性因素的影响,基于像素的条件随机场显著性检测方法通常具有模糊显著性边缘,具有边界图的超像素级“双环”中的每个节点不仅能收集更多的邻域交互信息,同时能收集到过度分割得到的边界先验知识,使得边界区域的形状与物体边界吻合同时使边界区域与更多邻域相连,最终获得清晰的对象边界。在视觉注意中引入条件随机场,将显著性检测问题公式化为超像素级图像上的条件随机场模型学习和推理问题,更符合人类视觉系统,且对于不同的数据集具有鲁棒性。

对于输入的图像,通过“双环”的方式得到最终的显著特征图。其中一环以空间包络特征查找与目标图像具有相似场景的候选图像作为训练集,线性迭代聚类算法将图像分割成一组超像素块,并为每一张图像单独训练一个条件随机场模型第二环将目标图像进行超像素分割后,对每个超像素快提取三种显著性线索,分别为背景图、局部对比图和中心偏置图。三种显著线索在不同情况下彼此互补。最后,依据显著性线索推断出最终的显著特征图。

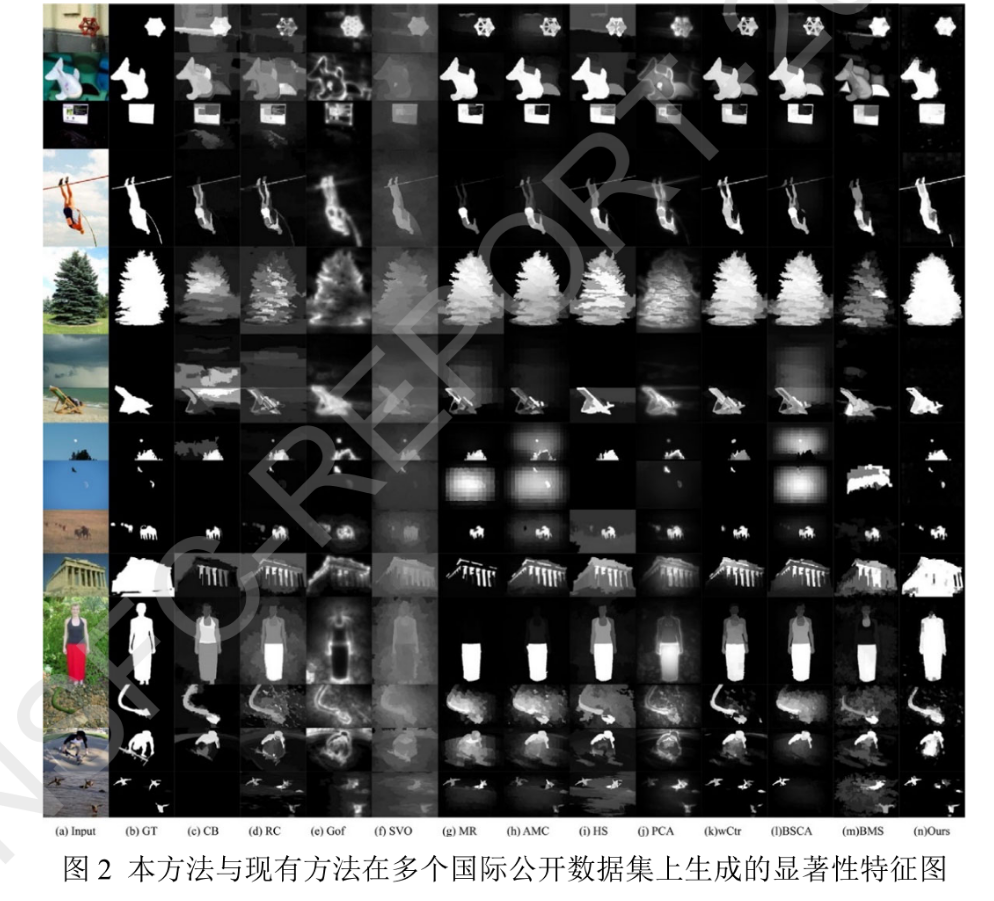

本方法的训练和测试在国际主流的公开数据库上进行,包括ASD,MSRASED,SOD,ECSSD和PASCAL-S数据库。下图给出了本方法与对比方法在多个数据库例图上的对比结果,从图中可以看出本方法得到的结果比现有方法具有更清晰的边缘与纯背景。

b)基于总方差的成对交互眼动辅助视频显著性检测

现有的利用光流估计之类的运动信息进行视频显著性检测的方法仍然无法准确提取视频中的目标对象,尤其是在相机镜头运动的情况下。针对此问题,提出了一种基于多色空间测地距离融合和基于总方差的成对交互模型的眼动辅助视频显著性检测方法,该方法利用了来自多个被试的注视点信息,其主要思想是逐步将注视范围扩展到显著区域,充分挖掘眼动数据的潜力,又有效消除了孤立眼动的干扰。基于最小二乘条件随机场及总方差,提出基于弱监督学习的视频显著性检测算法,准确抓取视频序列中必要的场景结构,有效生成显著特征图同时抑制背景噪声。通过构造前几帧中前景与背景之间潜在的成对关系来推断其余帧的显著性值,极大地缩短了标注时间。

首先,对收集到的多个被试的原始眼球注视点数据进行处理。滤除持续时间短或与其他被试有明显差异的注视点。然后,将眼睛注视点映射到过分割的视频帧,并提取每个帧中每个区域的多个色彩空间特征。计算以映射的注视区域为中心的测地距离矢量,将其融合以找到最相关的区域作为种子区域。接下来,将种子区域与相应区域的颜色特征结合在一起作为训练集。最后,利用最小二乘条件随机场来构造前景与背景之间的关系,并依此关系推断其余帧的显著性值。

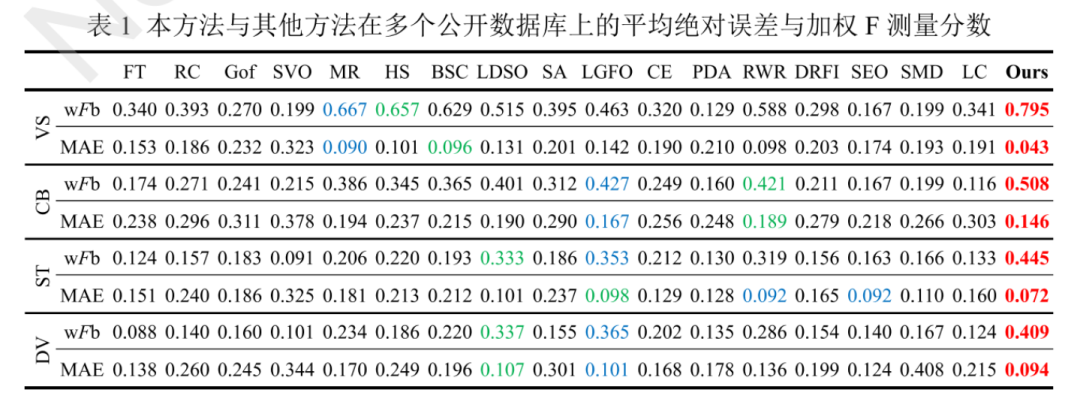

本方法在以下数据库上进行分析,包括videoSeg(VS),segTrackV2(ST)ObMiC(OB)及 DAVIS(DV),并利用了四个广泛使用的衡量标准,包括精确召回(PR)曲线、平均绝对误差(MAE)、F测量分数和加权F测量(wFb)分数来证明提出的TVPI模型的有效性。下表为本方法及现有方法在videoSegsegTrackV2,ObMiC及DAVIS数据库上的对比结果。结果显示该方法优于现有最新的视频显著性检测方法。

基于光谱先验的高光谱图像解混算法设计。a)研究了遥感影像与社交媒体数据融合方法的现状。完成了基于定位信息的社交媒体数据与遥感影像融合方法的综述。概述了融合过程所需要的技术和方法,并在其具体的城市观测应用方面进行了详细的综述,从四个方面进行了总结并阐明了其产生的实际效用以及未来的发展方向。b)研究了基于联合字典的结合光谱库的稀疏解混算法。首先基于聚类分析提出一种多字典学习方法并结合光谱库先验知识,然后改进稀疏推理过程引入协同学习,最后利用学习到的基于层次字典的联合字典对高光谱图像进行解混得到最终的丰度矩阵。c)研究了基于区域的多视角稀疏解混算法。首先将高光谱图像进行划分和聚类,构建多视角高光谱数据集,然后对多视角数据集进行多视角融合学习并结合光谱库先验知识,最后联合不同视角下的学习结果得到最终的丰度矩阵。相关研究成果发表在国际重要期刊IEEEJournalofSelected Topics inApplied Earth Observations and Remote Sensing, IEEE Geoscience and RemoteSensing LetterslNeurocomputing-。[1] Lin Qi, Jie Li, Ying Wang, and Xinbo Gao*, Urban Observation: Integration ofRemote Sensing and Social Media Data, lEEE Journal of Selected Topics inApplied Earth Observations and Remote Sensing (IEEE JSTARS), 2020[2] Lin Qi, Jie Li, Ying Wang, and Xinbo Gao*, Region-Based Multiview SparseHyperspectral Unmixing Incorporating Spectral Library. lEEE Geoscience andRemote Sensing Letter (EEE GRSL), Vol.16, No.7, pp.1140-1144, 2019.[3]Lin Qi, Jie Li, Xinbo Gao*,Ying Wang, Chongyue Zhao, and Yu Zheng, ANovel Joint Dictionary Framework for Sparse Hyperspectral UnmixingIncorporating Spectral Library,Neurocomputing, Vol.356, pp: 97-106, 2019.

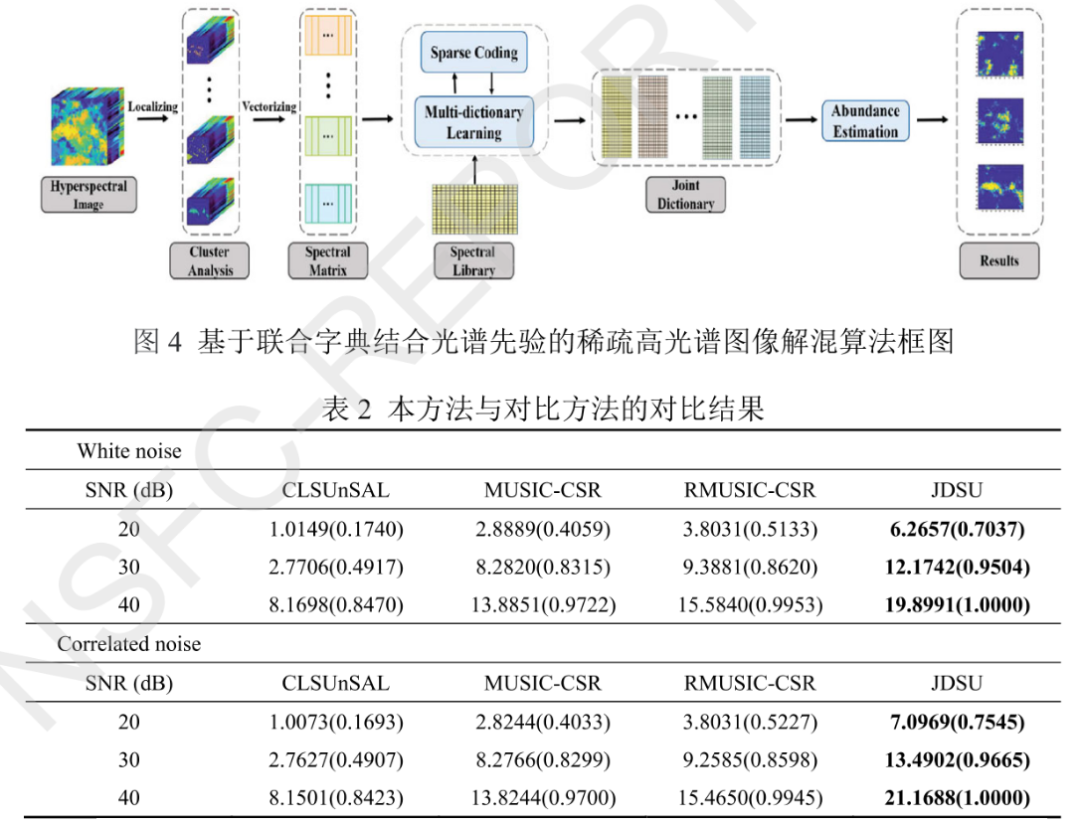

a)基于联合字典结合光谱先验的稀疏解混方法

高光谱图像具有很高的光谱分辨率,同时其空间分辨率不足,导致图像中存在大量的混合像元。混合像元的存在严重制约了高光谱图像的分类精度和定量化的发展。因此,针对高光谱图像混合像元的解混技术已成为高光谱遥感、计算机视觉和模式识别领域的重要课题。基于几何学和统计学的传统高光谱解混方法模型简单、速度快,但其精度不高。为了得到更好的丰度估计并充分利用先验知识,基于光谱库先验知识的半监督解混方法被提出。传统字典学习方法中,字典学习和稀疏表示过程都是针对整幅高光谱影像数据,而且是无监督的方式,没有加入光谱库这个先验知识,稀疏推理过程仅是针对单个像素点进行求解,传统字典学习方法的这些处理方式严重制约其在高光谱解混里的表现。为此提出了一种基于联合字典并结合光谱库的稀疏解混算法。

针对传统字典学习方法这些处理方式的不足,基于聚类分析提出了一种多字典学习的方法,并将光谱库这一先验知识加入到字典学习模型中,改进了稀疏推理过程并引入协同表示思想,利用局部端元的一致性进行局部协同学习。在整个字典的学习过程中有三个层次的字典原子选择过程,在层次选择后,得到最终的联合字典,最后,利用这一学习到的联合字典对整幅高光谱影像进行解混得到最终的丰度矩阵。

输入高光谱图像经过光谱聚类后将原始图像分割为不同的区域,经过向量处理后得到光谱矩阵,每一个类里包含不同的像素点,然后针对它们分别进行类内字典学习,学习过程中引入光谱库先验知识,并使用协同学习策略,同一端元会分布在不同类中,因此,同一端元会进行多次学习,从而提高端元学习的准确性和字典的性,同时,协同学习策略可自动的确定每一个类内的端元数目。最后将学习到的每一个字典进行联合得到最终的联合字典,对原始高光谱图像进行丰度估计得到最终的丰度图。

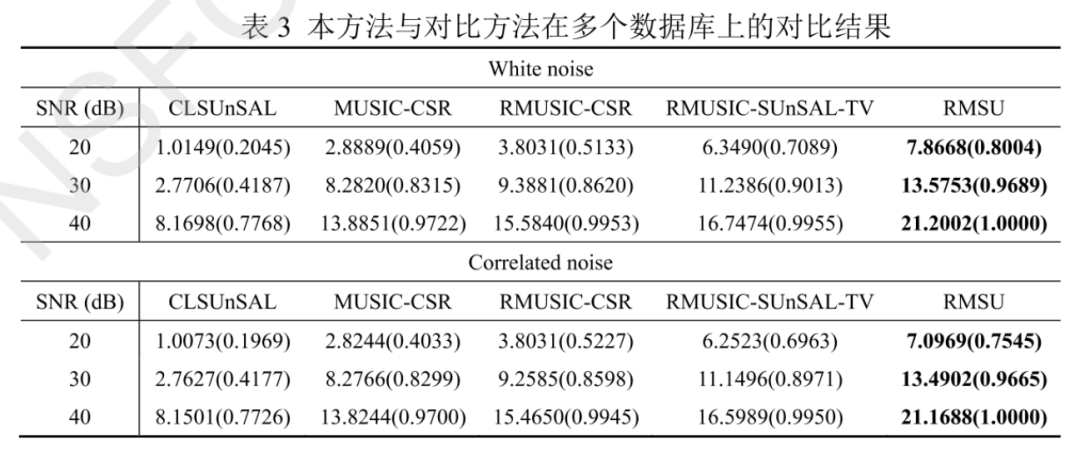

本方法通过在三个模拟高光谱数据集和一个真实高光谱数据集上的对比试验,验证了所提算法的有效性。所使用的光谱库包括U.S.Geological Survey(USGS)光谱库、NASA Advanced Spaceborne Thermal Emission and ReflectionRadiometer(ASTER)光谱库。不同的解混方法在光谱库中进行回归得到数据集中包含的端元的光谱曲线,并进行丰度估计得到丰度矩阵。表2给出了本方法与对比方法的对比实验结果,从从表中可以看出本方法具有比现有方法更好的精度且所得到的修剪字典包含更少的原子和更低的互相干性。

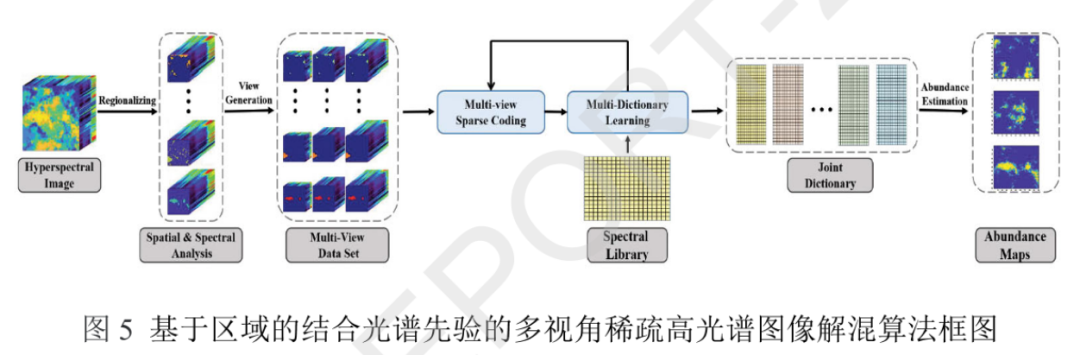

b)基于区域的结合光谱先验的多视角稀疏解混算法

当前的解混方法大部分都是利用高光谱影像的光谱信息进行解混,而忽略了高光谱影像的空间一致性。高光谱影像作为一个数据立方体,包含了丰富的光谱信息和空间信息,因此,针对多种信息空间的不同特性可以用来开发精度更高的解混算法。提出了一种基于区域的多视角稀疏解混算法。针对高光谱影像的特点利用光谱划分和聚类分析技术生成多视角的高光谱数据集,将高光谱影像不同波段的光谱信息和空间信息作为影像的不同视角。然后针对不同视角的高光谱影像数据集分别进行稀疏学习,同时,将光谱库这一先验知识引入到学习过程中。最后,将针对不同视角数据集的学习结果进行最终解混结果的联合并获得丰度矩阵。

本方法通过在两个模拟高光谱数据集和一个真实高光谱数据集上的对比试验,验证了所提算法的有效性。不同的解混方法在光谱库中进行回归得到数据集中包含的端元的光谱曲线,并进行丰度估计得到丰度矩阵。下表给出了本方法与对比方法的对比实验结果,从表中可以看出本方法具有比现有方法更高的精度。

图像去雾去噪视觉计算方法设计。a)研究了合成孔径雷达图像统计处理与分析,提出了基于贝叶斯非局部均值广义引导滤波的合成孔径雷达图像斑点噪声抑制方法。首先将线性形式的标准引导滤波拓展为非线性形式的广义引导滤波,并采用贝叶斯非局部均值和最大似然方法,分别估计广义引导滤波的非线性加权核函数与引导图像。

b)研究了基于局部特征分析的高分辨光学遥感图像雾霾消减方法。该方法从高分辨遥感图像和自然图像成像模型差异出发,证明了采用线性型进行雾霾消减的合理性,进而通过对雾霾图像局部特征的分析,构建了线性模型参数的估计方法。

c)研究了基于雾浓度预测的可见光遥感图像去雾方法。由于雾浓度在全局范围内的亮度变化是平缓的,而地表辐射具有大量的边缘跳变,因此通过在图像边缘处对初始雾浓度图的地表亮度进行抑制,得到精确的雾浓度图再用雾浓度图求多光谱图像各个通道对应的雾成分。由于雾浓度中不包含地表辐射亮度,因此从有雾图像中减去雾成分不会影响地物的光谱特性,图像的色彩看起来也比较自然。

d)研究了基于场景透射率自适应正则化的雾天图像复原方法。通过边界约束和非局部全变分正则化估计透射率,能够保持不同尺度的深度结构由于噪声的放大是由较低的透射率值引起的,距离越远失真程度越大,因此提出一种深度感知的自适应正则化图像复原方法,将深度因子引入优化方程中来加强对远处噪声和压缩块的平滑,而对近处区域施加较小的平滑操作,从而能在抑制噪声的同时较好地保持场景结构。相关研究成果已发表在国际期刊IEEETransactions on Geoscience and Remote Sensing (IEEE-TGRS)、NeurocomputingSignal Processing和IEEE Transactions on Image Processing (IEEE TIP)上[1]Weiping Ni, Xinbo Gao*, Despeckling of SAR Image Using Generalized GuidedFilter with Bayesian Nonlocal Means, IEEE Transactions on Geoscience andRemote Sensing (IEEE-TGRS), Vol. 54, No.1,pp.567-579,2016.

[2]Weiping Ni, Xinbo Gao*, and Ying Wang, Single Satellite lmage Dehazing viaLinear Intensity Transformation and Local Property Analysis, NeurocomputingVol. 175, pp.25-39, 2016.

[3] Qi Liu, Xinbo Gao*, Lihuo He, and Wen Lu, Haze removal for a single visibleremote sensing image, Signal Processing, Vol.137,pp33-43. 2017.[4]Qi Liu, Xinbo Gao*,Lihuo He, and Wen Lu, Single lmage Dehazing WithDepth-aware Non-local Total Variation Regularization, IEEE Transactions onImage Processing (IEEE TIP),Vol.27,No.10,pp.5178-5191.2018.

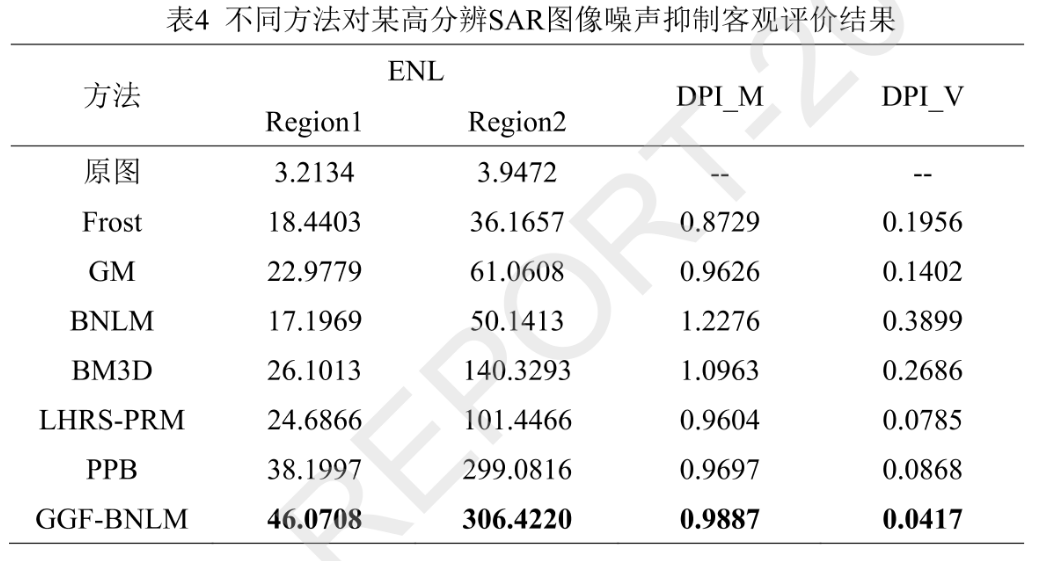

a)基于贝叶斯非局部均值广义引导滤波的SAR图像斑点噪声抑制方法针对高分辨SAR图像斑点噪声抑制问题,提出了一种基于广义引导滤波的处理方法,首先简要分析了SAR图像统计特性,然后将适用于加性高斯噪声的线性引导滤波推广为非线性的广义引导滤波,以用于存在乘性斑点噪声的SAR图像进而在贝叶斯非局部均值框架下推导出广义引导滤波非线性加权核函数计算表达式,并采用结合局部统计特性的最大似然方法对引导图像进行估计,最终完成斑点噪声的抑制处理。

考虑斑点噪声统计特性的乘性模型,结合引导图像,应用非线性加权核函数得到广义引导滤波输出。对于引导图像,引入局部统计量确定局部领域窗口类型,进而选用不同的滤波策略估计引导图像。对于非线性加权核函数,以贝叶斯非局部均值为基础,在过程中引入相似地物散射特性的局部图像块之间的相似度,并使用局部归一化因子调节观测图像与引导图像的关系。

基于真实获取的高分辨SAR图像,并结合相应的主客观评价方法,下表给出了本方法与对比方法的结果。实验验证了本方法的有效性,在斑点噪声平滑和像细节保持方面整体优于其他方法。

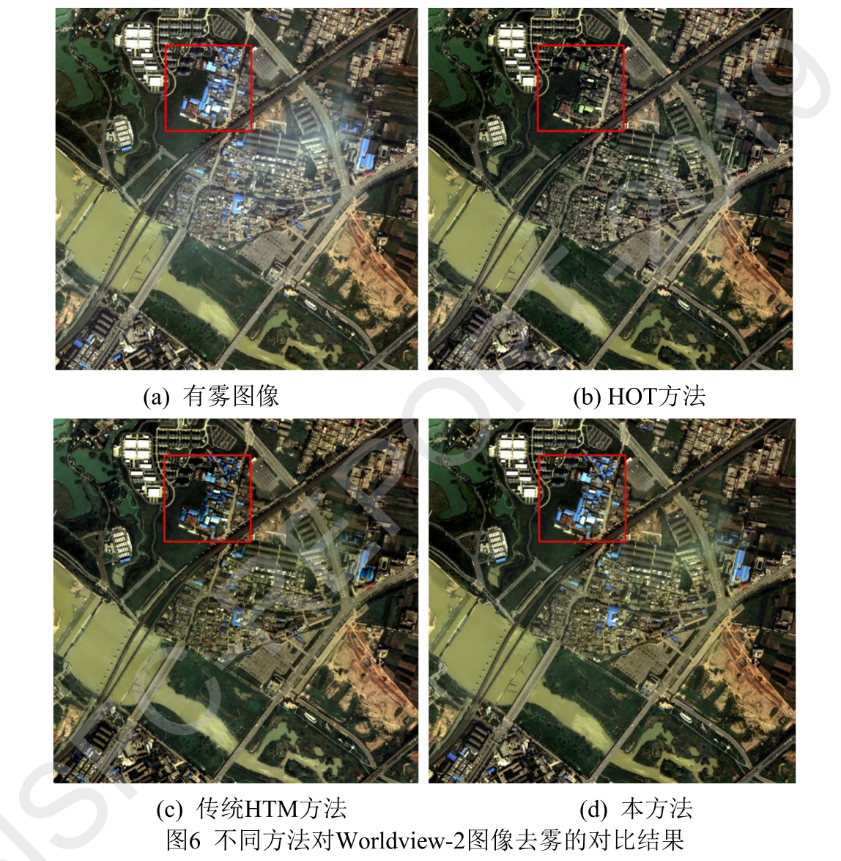

b)基于场景透射率自适应正则化的雾天图像复原方法

现有的去雾方法在对透射率图进行滤波去除纹理细节时,容易损伤结构边缘导致去雾图像在边缘处出现光晕,同时直接逆推成像公式进行去雾容易产生放大噪声和压缩的人工痕迹。针对这些问题,提出了一种对噪声和人工痕迹抑制的单幅图像去雾算法。透射率计算和无雾图像恢复分两步进行。首先,通过对成像模型应用边界约束来计算初始透射率图。然后通过使用非局部全变分(NLTV)正则化来对其进行修正。这种正则化方法能够有效处理细节和纹理,同时保留图像的重要结构。在复原场景辐射时,同样采用正则化的方法来处理噪声和压缩痕迹。由于噪声的放大效应取决于透射率,因此提出了透射率自适应的正则化复原模型最后提出了一种有效的交替优化算法来求解透射率和场景辐射的优化问题。

首先计算大气光,采用最小值滤镜对图像每个颜色通道进行滤波,滤波图像的每个通道的最大值被视为大气光的组成部分。然后估计初始透射率,假设局部块中的透射率是恒定的,并且在这个边界上应用最大滤波,则下限值与暗通道先验(DCP)一致。DCP结合对场景辐射的边界约束,并滤去图像细节即可得到估计初始透射率。应用大气光和初始透射率,并考虑加性噪声和压缩痕迹,可得到恢复场景辐射。为了抑制恢复时的噪声,采用优化的方法对初始透射率图进行改善,其中NLTV模型作为正则项避免过度平滑的人工痕迹。对于景深的引入,提出了一种透射率自适应的非局部全变分(TANLTV)模型,为不同区域去雾图像的非局部梯度分配由透射率得到的权重。

……

还有更多成果内容,详见项目结题成果报告。该项目报告共计119页,关注城市数据派微信公众号,在微信公众号对话框中输入241125,即可获得报告全文PDF的下载方式。

原文始发于微信公众号(城市数据派):基于视觉计算和感知模型,构建多元空间融合的图像质量评价新框架丨城市数据派

规划问道

规划问道