3 计算型城市设计:如何生成一千个设计方案得出最优解?

今日推送该系列第4篇:

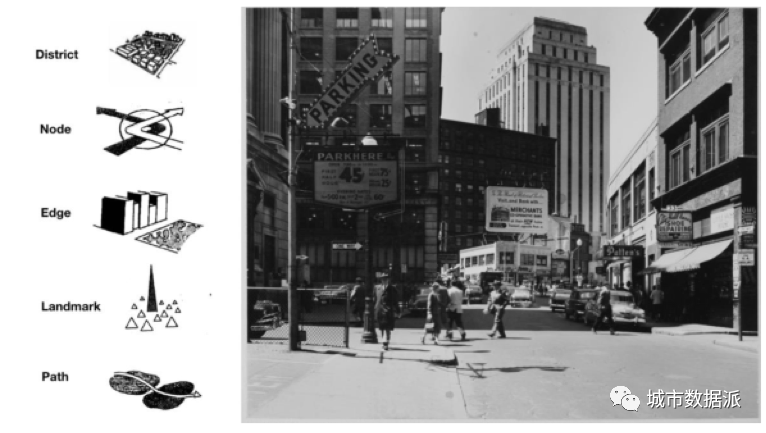

1960年,凯文·林奇(Kevin Lynch)发表了《城市意象》(The Image of City)一书,其中总结了城市设计的五个要素:道路、边界、区域、节点、标志物。这些要素并非彼此独立,而是共同帮助城市的使用者认识并理解城市的组织结构,从而对城市获得更加清晰的感知。而在1964年林奇的研究 “The View from the Road“中,他带着一部早期的车载相机在美国的数座大城市中,记录下了他驾驶沿途中所看到的场景变换。通过加速播放视频,可以呈现城市的规划和设计给人们带来的整体感受,从而来检验城市的“可读性”与“可意象性”。

▲ 城市设计的五个要素:道路、边界、区域、节点、标志物。这五个要素共同塑造着人们对城市的感受与体验

以林奇的这部著作为奠基,城市设计所带来的视觉上的连续性、统一性与逻辑性,及其对塑造人们对城市的感知和体验所产生的作用,成为了城市设计中一个重要的主题。尤其在设计的早期,对使用者视觉体验的考虑会在很大程度上影响设计的组织和架构。同时,也正因如此,在设计过程中,用于呈现视觉体验的渲染图就显得尤为必要。

然而,传统的渲染图制作存在着许多的难点与问题。首先,力求逼真的渲染图制作技术难度较高,且专业软件的学习往往有着非常陡峭的学习曲线。同时,这些渲染图也常常对设计的细节有着很高的要求,一些局部、细节的改动可能就需要花费大量的时间来对渲染图进行重制。

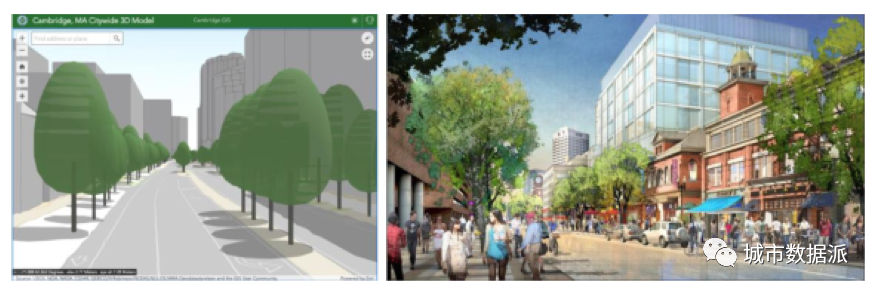

因此,在设计的初期阶段,设计师们对设计的视觉效果很难进行呈现——或是以一种极为抽象、难以让非专业人士获得感知的方式(下图左),或是追求精美而需要花费大量的时间,且过分强调细节而非整体(下图右)。同时,传统的渲染图常常还存在着过度美化与艺术化的问题。有些渲染图为了宣传目的,往往选择忽略周围的环境,而通过参数的调节来凸显场地本身,从而牺牲了部分真实性与准确性。

▲ 早期的渲染图或是过分抽象而让大众难以体会,或是太过精细而忽略了全貌

面对这些问题,MIT Media Lab在2019年设计了DeepScope —— 一个即时性、互动性的城市设计可视化平台。

简单来说,在这一平台上,设计师们可以在设计的初期阶段,通过调整实体的建筑体量模型,实时地得到视觉效果的反馈以及真实的渲染场景,从而在早期阶段就得以了解设计方案能够产生的视觉效果,以确保其视觉上的连续性与结构性。

1 基于生成对抗网络(Generative Adversarial Network)的图像生成算法;

2 由Cityscapes数据集训练出的图像生成模型;

3 一个实体的、可触摸的交互界面(Tangible User Interface, TUI)。

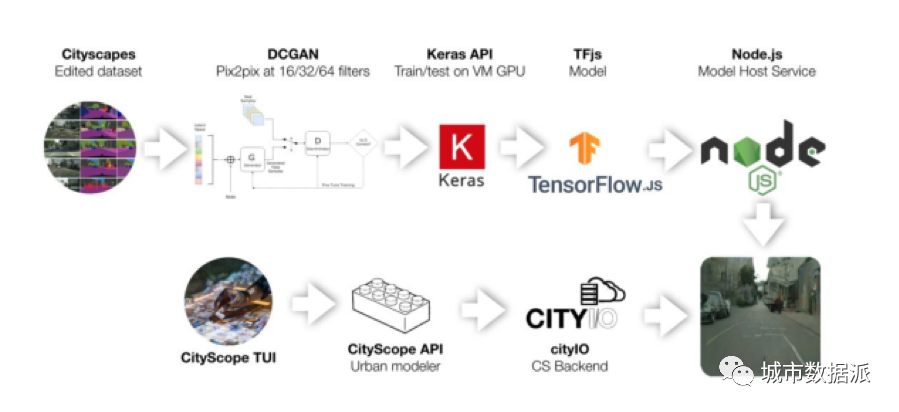

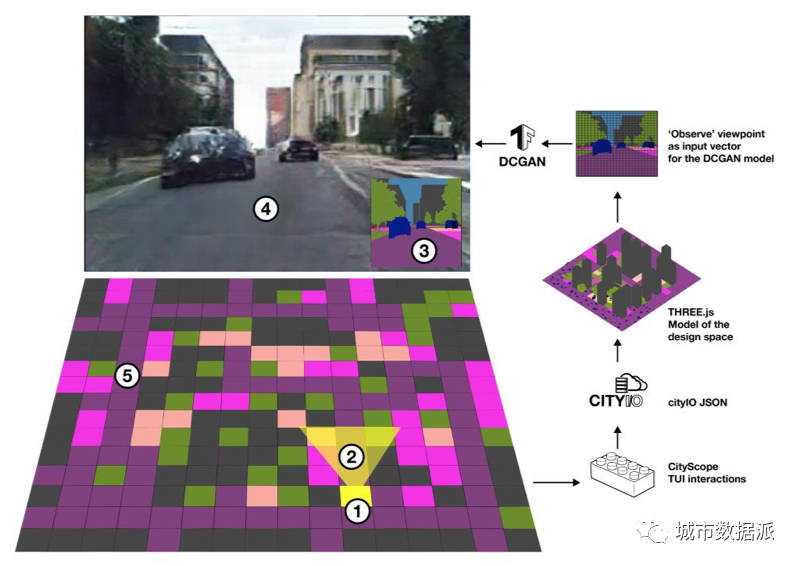

如下图所展示的,DeepScope平台的一端是用街景数据集训练得到的图像生成模型,另一端是从用户端收集到的用来生成街景图像的标签,将用户所提供的图像生成标签输入模型,最终就能得到输出的图像,进行场景的自动渲染。

近几年来,神经网络的流行对许多产业和研究群体都造成了巨大的冲击。从医学影像到股票市场,神经网络为理解数据规律并作出预测提供了新的方法。而DeepScope这一项目则使用了神经网络的一个变种——生成对抗网络。生成对抗网络可以根据大量的训练数据来生成新的数据。

深度卷积生成对抗网络

能够在大量的数据集中进行精确的特征识别是神经网络的一大优势。而这在上世纪80年代末期,就已经有了不少成功的应用。然而,根据既有数据集生成符合特征的新数据则仍然是一个复杂的问题。生成新数据不仅要求模型能够判断测试数据是否与训练数据具有相同的特征,还需要模型深度理解生成的数据结构。

由Ian Goodfellow提出的生成对抗网络(GAN)极大地促进了神经网络在数据生成上的应用。生成对抗网络包含着两个互相对抗的神经网络,彼此之间进行训练和对抗。首先,生成器网络负责生成与训练数据相符合的新数据样本,而另一边的判别器网络则要判断生成的数据样本是否符合原数据特征,如果不符合,则要对其进行判别。

在训练过程中,生成器网络需要不断地改进其生成的数据,直到判别器无法对其进行判别,而认定其与训练数据相符。同时,判别器也会不断地增强其判别能力,试图区分出生成数据与训练数据。训练可以以多种途径结束,但通常来说,一个生成数据与训练数据之间的最低近似值可以作为训练完成的标志。

DCGAN一个最为常见的用途就是进行标签与数据之间的转换(由标签生成数据,或是从数据识别标签)。

图像到图像的转换

生成对抗网络常常被用于生成新的数据,例如图像、视频与声音。而DCGAN最重要的用途就是pix2pix,也就是基于数据标签来生成所对应的数据,反之亦然。

这一方法可以让根据标签生成真实图像的功能得以实现。自从被发明以来,pix2pix就一直在被研究人员所改进,一方面需要降低其假阳性率,同时也减轻其对标签精准程度的依赖。同时,也有部分研究着重提高其可接受的图像分辨率。

这一项目的目的是搭建一个能够根据实体用户界面变化而实时改变的城市模型,并即时地生成其对应的街道景象。在硬件上,这一系统主要包括了一个实体的用户界面City Scope,用于快速地建模并给予视觉反馈。

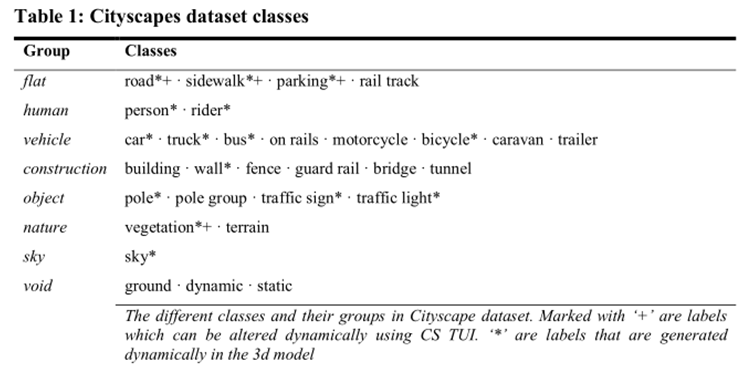

在该项目中,研究者们使用Cityscapes数据集训练了生成对抗网络模型。这一数据集包含着几个月时间内(春、夏、秋三季),从50多个的德国城市中,由车载相机所拍摄下的日间街景图片。每一张街景图片都对应有一张带有内容标签的图像。这些标签图像共有30种不同的颜色,每个颜色都代表着一种街道元素,包括大型的建筑和道路,也包括细节的街道标识等。

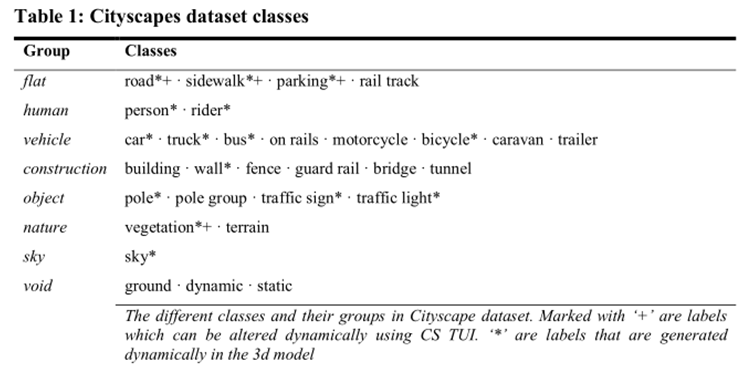

这一数据集中共有五千个带有详细标签的图像对(街景与标签),和两万个有粗略标注的图像对。以下的表格中列出了Cityscapes数据集中所使用的标签类型。“+”代表可以通过CityScope实体用户界面而改变的元素,“*”是在3d模型中可以实时生成的元素。

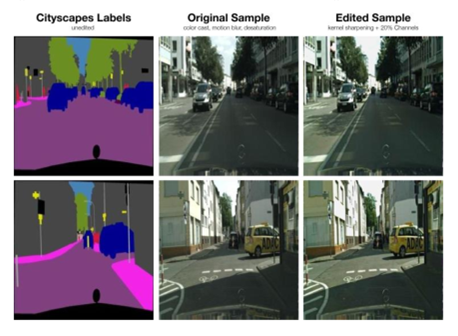

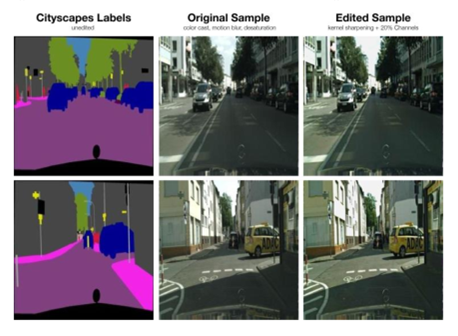

在这次项目中,2975对带有详细标注的图像被用于模型的训练,根据Isola等人的研究,这一数量也被证明是足够的。每一对街景与标签都被加和成一个512*256像素的图像,其中包含着街景与标签两种数据。而研究者通过对数据的检查,发现了几个问题:首先,由于图像都是于移动中的车上拍摄,运动模糊以及锐度不足是常见问题。

其次,由于拍摄地点位于德国,整体的光线及对比度趋于昏暗,并带有蓝绿色偏。为解决这些问题,研究者们设计了Open-CV算法来加强图像锐度,饱和度,以及去除色偏。这一算法被用于修正较低质量的图像样本,且只被用于街景图像,并不用于标签部分。

中列:原始的车载相机影像,具有明显的色偏、模糊与低饱和度

Pix2pix的流行也部分体现在其繁多的复制品与衍生品中。如同2.2节中所提到的一样,这一项目中所使用的模型采用了主流的pix2pix架构,同时做了细微的调整来加快预测速度并减轻模型体量。为在不同平台实现实时的渲染和输出,并省去复杂的安装步骤,研究人员在python上通过TensorFlow制作了pix2pix端口。

这一端口可以将模型导出成网页可使用的格式,并通过tensorflow.js库将其载入至Node.js环境中,使其可以在动态网站上运行,而无需远程服务器处理。

▲ DCGAN训练过程

研究人员通过调节模型的时期(epoch),观察参数对生成图片效果的影响,选择合适的参数

这些图像样本经过了64层过滤器,对模型进行了450个时期的训练。第一行分别是第一个、第75个、以及第150个时期训练后的结果。可以明显观察到,DCGAN所生成的图像有了更好的形态、颜色和锐度。下方一行则是200、275、350次训练后的结果,研究人员观察到了明显的退化,以及潜在的模式坍塌(mode collapse)。问题的原因可能是由于该图像中天际线与建筑形态的缺失。因此,研究人员认为该模型可以较好地预测带有右侧立面视角的街景,但对视觉消失点区域的预测则比较不稳定。

该模型含有两个相互对抗的神经网络:生成器与判别器。其中,生成器网络共有16层,并含有一个U-Net 解码-编码结构。首先的8层会将输入的矢量数据压缩进一个紧凑的隐矢量(Latent Vector)中。而U-Net的另一半则对其进行升采样。判别器网络的架构使用了Leaky ReLU作为激活函数,从而增加GAN训练的稳定性。在训练过程中,模型会产生两份相同的判别器网络,一个用于训练数据的学习,另一个则用于读取生成的新数据。

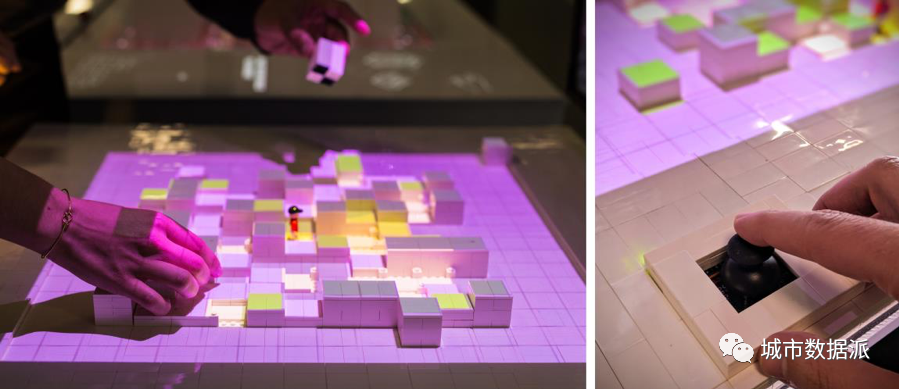

DeepScope另一个重要的组成成分则是一个实体的、可触摸的设计与交互界面,即Human-Compter Interaction(HCI)。研究者们提到,长久以来,城市设计的交互界面往往是高度专业化的电子平台,如AutoCAD、Rhino等,对使用者的技能有所要求,也并不适用于多方的合作。而实体的交互界面则更加符合人们的使用直觉,能让非专业的人群也加入到设计和讨论当中。

DeepScope团队所使用的CityScope(CS)是一个由MIT Media Lab研发,可以实现快速建模的实体设计平台。

首先,实体的城市建筑体量模型包含一个16*16网格化的桌面和数百个预先设有用途、密度、形态等标签的立方体块。使用者可以将这些体块任意移动,来生成不同的城市模型。同时,使用者也可以移动观察者模型的位置,并进行旋转、平移、缩放等行为,来模拟人们在不同位置的视角。

采集元件继而可以扫描模型,将观察者模型所观察到的实体信息(栅格图像数据)转化为电子信号,并将电子信号存储到云端服务CityIO上。然后,CS可以使用OpenCV对电子信息中的元素加以识别,识别出的内容被转化为矢量数据,输入至训练后的DCGAN模型中,根据街道元素标签生成接近真实的渲染图像。

▲ 使用者改变Cityscope的实体模型,经采集元件扫描后将模型信息转化为带有标签的矢量数据,从而进行渲染图像的生成

▲ 通过改变桌面上的模型,设计的参与者就可以在上方的屏幕中看到实时渲染出来的场景。

最终,团队所搭建处的DeepScope平台,其用户互动界面的响应速度达到了100ms,而经过多次训练的DCGAN模型,每次渲染也只需花费0.66秒。DeepScope的运作和响应速度使其渲染效果几乎达到了实时,且可以网页上实现运行,便于设计师的使用。而这也是DeepScope最为核心的优势——它将设计的可视化变得更加自动与简单,同时也让视觉效果更加趋向真实。

而更重要的是,这种以机器学习为基础的渲染方式并不需要过多的细节设计,因此可以在设计初期,确定空间结构与控制建筑体量阶段进行使用,让设计师们有机会更早地了解到人们的视觉感受与使用体验,从而打造场所的可读性和可意象性。同时,一个友好的、可触摸的实体用户界面也积极地鼓励着设计过程中的多元合作。

如同上一篇文章中提到的,在城市设计影响愈发深远、要求愈发复杂的今天,让更多元的群体参与到设计当中,逐渐成为了行业不可避免的趋势。这也即将为城市设计提供一种新的工作模式与逻辑。

然而,DeepScope也不可避免地也存在着几个问题。首先,用于训练模型的数据集的收集与标注需要大量的人力与时间——Cityscapes数据集的收集和整理花费了数月,未来这些数据如何能更高效率地被收集、处理仍是一个问题。

同时,作者也提到,在试验过程中,目前DCGAN模型的表现并不稳定,对场景的渲染有时不成功,或是渲染结果不一致,因此想要将其投入实际使用还需要更多的学习与训练。最后,该工具的另一个局限则在于,由于训练数据均为街景图像,其输出的结果相应地也只能是行人视角的图像,而无法转换为其他角度,而这在很大程度上限制了视觉效果的呈现。

综合而言,DeepScope所面临的最大挑战仍然在于它的核心算法——DCGAN。正如前面提到的,这一模型在使用中时常显得难以预测。虽然研究者认为这在一定程度上体现了其设计的自由度,但在实际使用中却可能让使用者感到不安与混乱。

同时,作者也提到DCGAN也携带着潜在的偏见:比如训练数据的选择可能会严重影响渲染的效果,而模型网络的架构也会对结果有所影响。但是研究者更加相信,更合理的网络架构和更大量的训练能够在未来逐步地解决这些问题,而更多的图像生成方法也正在被研究、设计出来。

硬件与软件的不断升级也有机会将这项技术带到更多的场景中,让更多的人共同参与和使用。而更为广泛地来说,DeepScope所呈现出的也是计算型设计的未来——用精密的计算来辅助传统的城市设计,为设计提供新的灵感。

商业投稿、合作等,请联系客服微信号,加好友必须备注:合作+姓名

原文始发于微信公众号(城市数据派):未来设计:如何打造即时性互动性的城市设计可视化平台?丨城市数据派

规划问道

规划问道